Femrat nga Europa Lindore apo Amerika Jugore janë shumë seksi dhe e kanë mendjen për takime dashurie? Një analizë e Deutsche Welles tregon, se Google shërben si katalizator për klishetë seksiste.

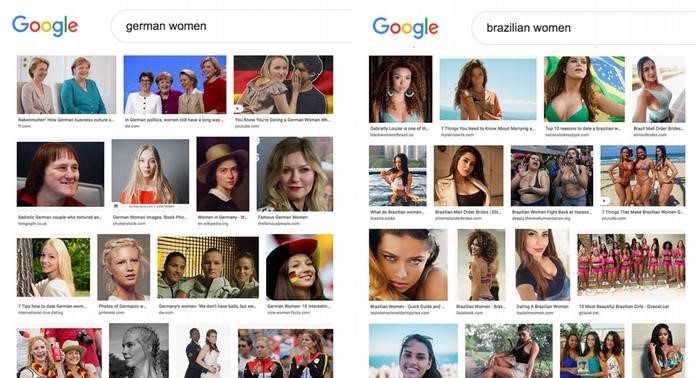

“Google Images” i jep fytyrë botës: Kush do të shohë si duket ai apo ajo do të futet në kërkim në google njëherë. Një hulumtim i Deutsche Welles arrin në konkluzionin, se në çfarë rezultatesh të shtrembëruara të çojnë algoritmet e gjigandit kërkimor. Gazetaret e gazetarët e Deutsche Welles kanë analizuar më shumë se 20 mijë pamje dhe faqe web-i. Rezultati: Kërkimet e fotove në anglisht me fjalëkyçe si “femra braziliane”, “femra domenikane”, “femra tajlandeze”, “femra ukrainase” të çojnë më shumë në pamje vajzash të reja në poza dhe veshje provokuese, se sa kërkimi në Google për “femra amerikane”. Kurse po të kërkosh për “femra gjermane” dalin më shumë pamje sportistesh dhe politikanesh. Ky është një model që kuptohet menjëherë, sepse e konfirmojnë kërkimet e thjeshta. Por analizimi i rezultateve është më i vështirë. Përcaktimi i asaj, se çfarë e bën një pamje seksiste, natyrisht që është subjektive dhe varet nga konteksti kulturor, moral dhe social.

Çfarë e bën një pamje provokuese?

Për të klasifikuar mijëra pamje, analiza e DW-s u mbështet në mekanizmin e vetë Google-it “Cloud Vision Safesearch”, një aplikacion i inteligjencës artificiale. Ky software përpunues pamjesh është i programuar që të dallojë pamje me një përmbajtje të caktuar. Google e përdor atë për të shënjuar pamje “provokuese” me veshje seksi, ku lakuriqësia e fshehur me strategji ekspozohet me poza provokative. Po ashtu identifikohen edhe pamje të pjesëve të caktuara të trupit. Në kërkimin me fjalëkyçin gra domenikane apo braziliane, Google ofroi deri në 40% pamje provokuese. Rezultati kërkimit me fjalëkyçin gra amerikane ka nxjerrë vetëm 5% pamje të tilla, kërkimi me fjalëkyçin gra gjermane vetëm 4%.

Përdorimi i algoritmeve të tillë është i kontestuar, sepse përdorimi i programeve të tillë kompjuterikë i nënshtrohet, ndoshta edhe më shumë, paragjykimeve apo diktateve të ndryshme kulturore se sa syri njerëzor. Në një moment tjetër ky software i posaçëm ka prodhuar rezultate raciste. Inteligjenca artificiale e Google që punon si një sistem i mbyllur mund të rezultojë në shtrembërime në rezultate. Nga ana tjetër verifikimi mekanik i pamjeve që Cloud Vision i kategorizoi si pamje eksplicite, tregoi se rezultati ia vlejti: Ato janë një vështrim se si teknologjia e vet Google vlerëson pamjet që tregohen nga programi kërkues.